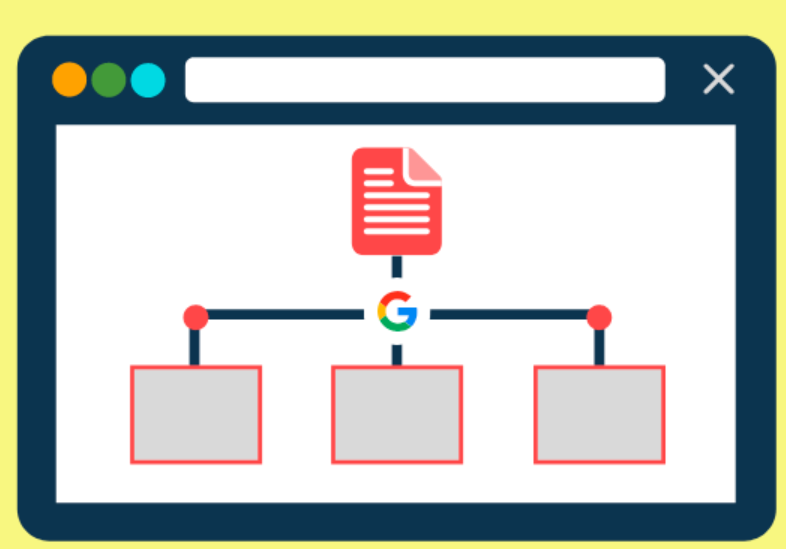

网络爬虫,通常被称为蜘蛛或机器人,是自动浏览互联网页面以收集信息的程序。搜索引擎利用这些爬虫来发掘内容,并将其纳入索引,即存储在庞大数据库中的信息。这些程序通过跟随网站上的链接来发现内容。然而,这个过程并不总是畅通无阻,有时会出现所谓的抓取错误。

那么,什么是抓取错误呢?简单来说,抓取错误发生在搜索引擎的爬取工具无法正常访问网页的时候。在这种情况下,像Google这样的搜索引擎无法充分理解和探索网站的内容或结构。这无疑是一个问题,因为抓取错误可能会阻止网页被搜索到,进而影响到网页被编入索引、出现在搜索结果中,以及为网站带来免费的流量。

Google将抓取错误分为两大类:网站错误和URL错误。下面我们将详细探讨这两种错误。

首先是网站错误,这类错误可能会影响整个网站的抓取。常见的问题包括服务器错误、DNS错误和robots.txt错误。

服务器错误发生当服务器无法正常加载页面,通常表现为5xx HTTP状态代码。具体包括:

- 内部服务器错误(500):服务器无法处理请求,有时也可能是当无法获取更具体错误信息时触发。

- 网关错误(502):作为网关的服务器收到了无效的响应。

- 服务不可用错误(503):服务器当前不可用,通常在服务器正在进行维护或更新时出现。

- 网关超时错误(504):作为网关的服务器没有在预期时间内收到响应,这可能是由于网站流量过大造成。

当搜索引擎频繁遇到5xx错误时,它们会减慢对网站的抓取速度。这意味着Google等搜索引擎可能无法发现并索引网站的所有内容。更严重的是,Google可能会从其索引中移除那些经常出现5xx问题的网址。因此,使用站点审核来跟踪任何5xx错误是非常必要的。

DNS错误是指搜索引擎无法连接到网站的域。DNS通过将域名与IP地址相匹配,使得人们和计算机可以更轻松地在网络上相互通信。如果没有DNS,我们将不得不手动输入网站的IP地址来访问它们,而不是使用URL。DNS错误相对较少见,但可能会出现以下情况:

- DNS超时:DNS服务器没有及时响应搜索引擎的请求。

- DNS查找失败:搜索引擎无法访问网站,因为DNS服务器找不到域名。

Robots.txt错误发生在搜索引擎无法访问网站的robots.txt文件时。这个文件告诉搜索引擎哪些页面可以抓取,哪些不可以。robots.txt文件主要包括三部分:

- 用户代理:标识爬虫的行,空格代表所有搜索引擎机器人适用。

- 禁止/允许:指示搜索引擎机器人是否可以抓取网站或其部分内容。

- 站点地图:指示网站地图位置的行,帮助爬虫更快地发现和理解网站结构。

URL错误则仅影响网站上特定页面的可抓取性。

404错误是最常见的URL错误之一,意味着搜索引擎机器人无法找到该URL。这可能发生在:

- 您更改了页面的URL,但未更新指向旧链接的引用。

- 您从网站中删除了页面或文章,但未设置重定向。

- 您的链接已损坏,例如URL中存在错误。

如今,许多公司都使用自定义404页面来改善用户体验,并与网站的设计和品牌保持一致。